El principio de ventaja acumulativa enuncia que una vez que un agente o individuo consigue una pequeña ventaja sobre el resto de la población ésta tenderá a acumularse a lo largo del tiempo, mejorando así la situación del agente según la métrica que define esta ventaja. Este principio se resume bien mediante expresiones como "los ricos cada vez se vuelven más ricos", "el éxito engendra éxito" o si tomamos un tono más bíblico, el denominado principio de Mateo:

(...) al que más tiene más se le dará, y al que menos tiene, se le quitará para dárselo al que más tiene.

Enunciado de manera formal por Robert K. Merton a finales de los años sesenta, surgió como un modelo que describía cómo los científicos que al comienzo de sus carreras obtenían más publicaciones, conseguían, ya con sus carreras más avanzadas, un mayor éxito respecto al de sus colegas.

El principio de ventaja acumulativa fundamenta la desigualdad en la vida diaria. Partamos de una situación inicial en la que todos los sujetos son iguales, digamos que nos encontramos en un aula de primer curso en un colegio. Por el motivo que sea, el maestro trata de manera diferente a ciertos alumnos, ya sea beneficiándolos o perjudicándolos. Pese a que no suceda en todos los casos, aquellos alumnos que cuentan con el favor del maestro conseguirán mejores notas que aquellos que no cuentan con esta ventaja. Estas notas pueden llevar a que otros docentes también les tengan estima, mejorando su condición. Desgraciadamente, la situación contraria también se da: aquellos a los que se les tiene "manía" muy pocas veces llegan a alcanzar a aquellos que cuentan con el favor del maestro. No estoy diciendo que ésta sea la única variable que afecte al rendimiento escolar, pero pequeñas diferencias al inicio, como pueden ser el entorno familiar o académico cuando se es niño, reducen las oportunidades de alcanzar las metas en comparación con otros individuos que han tenido un comienzo más favorable. Es por eso por lo que esta situación de éxito o fracaso se autoperpetúa, ya que las generaciones posteriores heredarán parte de esta ventaja o desventaja inicial, siendo muy dificil frenar el ciclo.

Esta situación no sólo afecta a los primeros años de vida, sino que se refuerza cada vez que empezamos una nueva etapa. Por ejemplo, la obtención de un mejor primer empleo lleva a que se obtenga un mejor segundo trabajo y así sucesivamente. Dos personas muy similares, por puro azar pueden conseguir trabajos iniciales ligeramente diferentes, lo cual puede puede conllevar a que con el paso de los años uno de las personas esté en una situación mucho mejor que la otra, ya no sólo por azar inicial sino porque la secuencia de empleos le ha llevado a desarrollarse como mejor profesional, autoperpetuando esta situación inicial favorable. En marketing también se da esta situación y recibe el nombre de ventaja del primer movimiento ( first-mover advantage ) la cual explica cómo en ciertos nichos de mercado sin ocupar el que obtiene la ventaja es aquel que efectúa el primer movimiento respecto. Es siempre el mismo proceso: una ventaja inicial conlleva una leve mejora respecto al resto, inicialmente en un sólo aspecto pero termina afectando por completo al agente. Si retomamos el ejemplo de la situación laboral, quién consiguió el primer mejor trabajo puede que sea un mejor profesional al cabo de los años (lo cual puede verse como una mejora en el desarrollo cognitivo), pero también tendrá más dinero (mejora económica) y, tal y como están las cosas ahora mismo, podrá disponer de una mejor cobertura sanitaria ( mejora en la salud ).

Lo interesante es que la idea subyacente a este proceso es sencilla de simular por ordenador. Imaginemos una situación en la que tenemos una red de conexiones entre personas. Al comienzo la población es pequeña y todos se conocen entre sí, pero poco a poco introducimos nuevos individuos que se conectan a los ya presentes. La probabilidad de que un nuevo individuo se conecte a uno ya existente es proporcional al número de conexiones que ésta posee. Hemos dicho que inicialmente todos tienen las mismas conexiones, por lo que todos tienen la misma probabilidad de recibir un nuevo enlace. El video bajo estas líneas es la respuesta a esta situación: conforme pasa el tiempo los que inicialmente tuvieron la suerte de conseguir más enlaces se hacen cada vez más fuertes. Os recomiendo también que echéis un vistazo a este enlace en el que existe una versión interactiva del mismo proceso que se ve en el vídeo inferior.

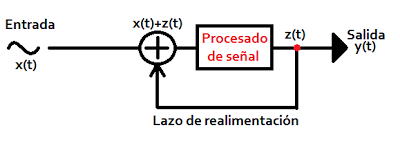

Al final de lo que se dispone es de lo que se llama una distribución acorde a la ley de potencias. Lo que se traduce en términos comunes en que "hay muy pocos que tienen mucho y muchos que tienen poco". En la figura inferior se puede ver cual sería la distribución del número de enlaces (eje y) respecto al número de individuos (eje x) en una situación similar a la que veíamos en el video. Muy pocos (hacia la izquierda) poseen la mayor parte del area de la gráfica, mientras que existen muchos (hacia la derecha) que disponen de muy poco.

|

| Ley de potencias / Wikipedia |

Pepe "Puertas de Acero" Pérez